Máy chủ GPU NVIDIA

Trong kỷ nguyên trí tuệ nhân tạo và dữ liệu lớn, máy chủ GPU NVIDIA đang trở thành nền tảng hạ tầng cốt lõi cho nhiều doanh nghiệp. Đây là hệ thống máy chủ được tích hợp các GPU chuyên dụng của NVIDIA nhằm tăng tốc xử lý các tác vụ nặng như AI, deep learning, phân tích dữ liệu và mô phỏng khoa học.

1. Máy chủ GPU NVIDIA là gì?

Máy chủ server GPU NVIDIA (hay còn gọi là NVIDIA GPU server) là hệ thống máy chủ được thiết kế để tích hợp một hoặc nhiều GPU chuyên dụng bên cạnh CPU. Trong khi CPU xử lý các tác vụ tuần tự và điều phối hệ thống, GPU đảm nhiệm các phép tính song song với cường độ cao — đặc biệt phù hợp cho:

- Huấn luyện mô hình AI và machine learning

- Deep learning và xử lý mô hình ngôn ngữ lớn (LLM)

- Phân tích dữ liệu lớn (Big Data)

- Render đồ họa, mô phỏng 3D và tính toán khoa học

Nhờ khả năng mở rộng linh hoạt (multi-GPU), máy chủ AI sử dụng GPU NVIDIA có thể đáp ứng từ nhu cầu của startup công nghệ đến trung tâm dữ liệu quy mô lớn.

2. Lịch sử phát triển của máy chủ GPU NVIDIA

Lịch sử phát triển của máy chủ GPU NVIDIA gắn liền với sự trỗi dậy của AI, deep learning và trung tâm dữ liệu hiện đại. Từ một công ty tập trung vào GPU đồ họa cho game, NVIDIA đã từng bước chuyển mình thành tập đoàn dẫn đầu trong lĩnh vực tính toán tăng tốc (accelerated computing).

Giai đoạn 1993 – 2005: Nền tảng GPU đồ họa

NVIDIA được thành lập năm 1993 và nhanh chóng nổi tiếng với GPU dành cho gaming và đồ họa 3D. Thời điểm này, GPU chủ yếu phục vụ hiển thị hình ảnh, chưa được sử dụng rộng rãi cho tính toán khoa học hay AI. Tuy nhiên, kiến trúc xử lý song song của GPU đã đặt nền móng cho các ứng dụng ngoài đồ họa sau này.

Giai đoạn 2006 – 2012: Bước ngoặt với CUDA và tính toán song song

Năm 2006, NVIDIA ra mắt nền tảng CUDA – một bước ngoặt lớn cho ngành công nghệ. CUDA cho phép lập trình viên khai thác GPU cho các tác vụ tính toán tổng quát (GPGPU), mở đường cho GPU tham gia vào:

- Tính toán hiệu năng cao (HPC)

- Nghiên cứu khoa học

- Phân tích dữ liệu

Đây là thời điểm GPU bắt đầu xuất hiện trong các máy chủ chuyên dụng, thay vì chỉ nằm trong máy tính cá nhân.

Giai đoạn 2013 – 2019: Bùng nổ Deep Learning và trung tâm dữ liệu

Khi deep learning phát triển mạnh, GPU NVIDIA trở thành phần cứng lý tưởng để huấn luyện mạng nơ-ron sâu. Các dòng GPU trung tâm dữ liệu như Tesla và sau đó là A100 ra đời, thúc đẩy sự hình thành của các máy chủ GPU NVIDIA chuyên biệt cho AI.

NVIDIA cũng giới thiệu hệ thống tích hợp sẵn như NVIDIA DGX-1 – được xem như siêu máy tính AI thu nhỏ dành cho doanh nghiệp và phòng nghiên cứu. Đây là cột mốc đánh dấu NVIDIA không chỉ bán GPU mà còn cung cấp giải pháp hạ tầng AI hoàn chỉnh.

Giai đoạn 2020 – nay: Kỷ nguyên AI, LLM và Generative AI

Sự bùng nổ của mô hình ngôn ngữ lớn (LLM) và Generative AI đã đẩy nhu cầu server GPU NVIDIA lên mức kỷ lục. Các GPU trung tâm dữ liệu thế hệ mới như NVIDIA A100 và NVIDIA H100 được thiết kế chuyên biệt cho AI training và inference quy mô lớn.

Hiện nay, máy chủ GPU NVIDIA đã trở thành nền tảng tiêu chuẩn trong:

- Trung tâm dữ liệu hyperscale

- Công ty AI và startup công nghệ

- Doanh nghiệp triển khai AI nội bộ

- Nghiên cứu khoa học và mô phỏng công nghiệp

3. Máy chủ GPU NVIDIA hoạt động như thế nào?

Để hiểu vì sao máy chủ GPU NVIDIA lại đóng vai trò quan trọng trong AI và tính toán hiệu năng cao, chúng ta cần xem cách hệ thống này vận hành. Khác với máy chủ truyền thống chỉ dựa vào CPU, server GPU NVIDIA kết hợp CPU để điều phối và GPU để tăng tốc xử lý các tác vụ tính toán song song phức tạp.

Trong mô hình này:

- CPU chịu trách nhiệm quản lý hệ điều hành, phân bổ tài nguyên và xử lý tác vụ tuần tự.

- GPU NVIDIA đảm nhiệm các phép tính ma trận, tensor và thuật toán AI đòi hỏi hàng triệu phép tính đồng thời.

Kiến trúc song song của GPU

CPU được thiết kế để xử lý một số lượng nhỏ tác vụ phức tạp theo thứ tự tuần tự. Thông thường, CPU máy chủ có từ vài chục lõi xử lý mạnh mẽ nhưng tập trung vào độ chính xác và khả năng điều phối hệ thống.

Ngược lại, GPU có hàng nghìn lõi nhỏ hơn, được tối ưu cho xử lý song song. Điều này có nghĩa là GPU có thể thực hiện cùng lúc rất nhiều phép tính tương tự nhau — đặc biệt lý tưởng cho:

- Huấn luyện mô hình deep learning

- Xử lý hình ảnh và video

- Tính toán khoa học quy mô lớn

- Phân tích Big Data

Chính kiến trúc song song này khiến máy chủ GPU NVIDIA trở thành lựa chọn hàng đầu cho các workload AI hiện đại.

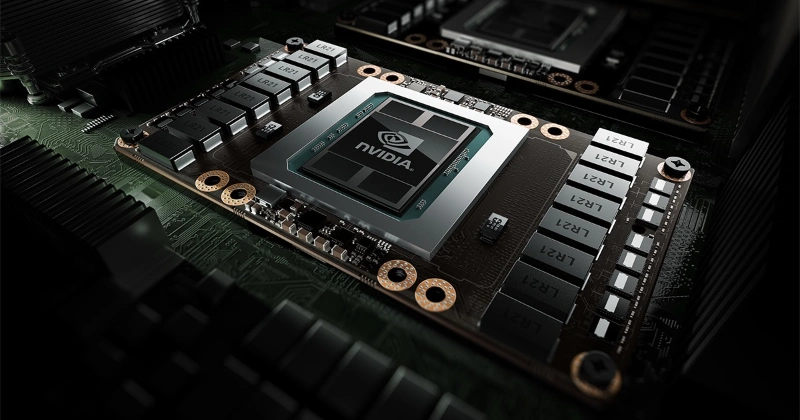

Khả năng xử lý hàng nghìn lõi tính toán đồng thời

Một GPU trung tâm dữ liệu của NVIDIA có thể chứa hàng nghìn lõi CUDA hoạt động đồng thời. Khi huấn luyện một mô hình AI, hàng triệu phép nhân và cộng ma trận cần được thực hiện liên tục. GPU xử lý các phép tính này nhanh hơn CPU nhiều lần nhờ:

- Khả năng chia nhỏ tác vụ thành nhiều luồng xử lý

- Bộ nhớ băng thông cao (HBM)

- Tối ưu phần cứng cho phép tính vector và tensor

So sánh hiệu suất xử lý AI giữa CPU và GPU

Trong môi trường AI và deep learning, GPU thường mang lại hiệu suất cao hơn CPU từ 10x đến 100x, tùy bài toán.

- CPU phù hợp cho tác vụ logic, điều phối và ứng dụng doanh nghiệp truyền thống.

- GPU phù hợp cho huấn luyện mạng nơ-ron sâu, xử lý dữ liệu lớn và mô hình ngôn ngữ lớn (LLM).

Vì vậy, các máy chủ deep learning hiện đại hầu như đều tích hợp nhiều GPU để tối ưu hiệu năng.

4. Công nghệ GPU của NVIDIA

Không chỉ mạnh về phần cứng, NVIDIA còn xây dựng hệ sinh thái công nghệ toàn diện giúp server GPU NVIDIA đạt hiệu suất tối đa trong trung tâm dữ liệu.

Kiến trúc CUDA

CUDA (Compute Unified Device Architecture) là nền tảng lập trình song song do NVIDIA phát triển. CUDA cho phép lập trình viên sử dụng GPU như một bộ tăng tốc cho các ứng dụng AI, HPC và phân tích dữ liệu.

Nhờ CUDA:

Các framework như TensorFlow và PyTorch có thể khai thác tối đa sức mạnh GPU

- Doanh nghiệp dễ dàng phát triển và triển khai ứng dụng AI

- Hiệu suất được tối ưu ở cả cấp độ phần cứng và phần mềm

Tensor Cores dành cho AI

Tensor Cores là các lõi chuyên biệt được tích hợp trong GPU NVIDIA thế hệ mới như NVIDIA A100 và NVIDIA H100.

Các lõi này được thiết kế riêng cho phép tính tensor và ma trận — cốt lõi của deep learning. Nhờ Tensor Cores:

- Tốc độ training mô hình tăng mạnh

- Hiệu suất inference được cải thiện

- Tối ưu xử lý mô hình AI quy mô lớn

NVLink và khả năng mở rộng đa GPU

Trong các hệ thống máy chủ AI quy mô lớn, một GPU là chưa đủ. NVIDIA phát triển công nghệ NVLink — kết nối tốc độ cao giữa nhiều GPU trong cùng hệ thống.

Lợi ích của NVLink:

- Tăng băng thông trao đổi dữ liệu giữa GPU

- Giảm độ trễ

- Cho phép huấn luyện mô hình lớn vượt quá dung lượng VRAM của một GPU

5. Các dòng GPU NVIDIA phổ biến cho máy chủ

Khi xây dựng máy chủ GPU NVIDIA, việc lựa chọn đúng dòng GPU là yếu tố quyết định đến hiệu năng, chi phí đầu tư và khả năng mở rộng trong tương lai. Tùy vào mục đích sử dụng như AI training, inference, HPC hay đồ họa chuyên nghiệp, doanh nghiệp có thể lựa chọn các dòng GPU NVIDIA cho server khác nhau.

NVIDIA A100

NVIDIA A100 là một trong những GPU trung tâm dữ liệu mạnh mẽ và phổ biến nhất dành cho AI training và tính toán hiệu năng cao (HPC). Được xây dựng trên kiến trúc Ampere, A100 cung cấp hiệu suất vượt trội cho các workload AI quy mô lớn.

Hiệu suất cho AI training và HPC

A100 được trang bị Tensor Cores thế hệ mới, tối ưu cho phép tính tensor và ma trận — nền tảng của deep learning. GPU này hỗ trợ:

- Huấn luyện mô hình deep learning quy mô lớn

- Xử lý dữ liệu khoa học phức tạp

- Mô phỏng và tính toán HPC

- Phân tích Big Data

Ứng dụng trong trung tâm dữ liệu lớn

A100 thường được triển khai trong các hệ thống multi-GPU hoặc cụm máy chủ AI để phục vụ:

- Trung tâm dữ liệu hyperscale

- Công ty AI phát triển mô hình ngôn ngữ lớn

- Tổ chức nghiên cứu khoa học

Đây là lựa chọn lý tưởng cho doanh nghiệp cần GPU NVIDIA cho deep learning ở quy mô enterprise.

NVIDIA H100

NVIDIA H100 là thế hệ GPU cao cấp tiếp theo, được xây dựng trên kiến trúc Hopper. Đây là dòng GPU được thiết kế đặc biệt để đáp ứng nhu cầu bùng nổ của Generative AI và mô hình ngôn ngữ lớn (LLM).

Kiến trúc Hopper tiên tiến

H100 sở hữu các cải tiến quan trọng:

- Tensor Cores thế hệ mới tối ưu cho AI

- Hiệu suất tính toán FP8 dành cho mô hình AI hiện đại

- Băng thông bộ nhớ cao hơn so với A100

Tối ưu cho Generative AI và LLM

H100 đặc biệt phù hợp cho:

- Huấn luyện và triển khai mô hình ngôn ngữ lớn

- Ứng dụng chatbot AI

- Hệ thống Generative AI

- AI đa phương thức (multimodal AI)

Nếu doanh nghiệp tập trung vào phát triển AI tiên tiến, H100 là lựa chọn hàng đầu trong hệ sinh thái GPU NVIDIA cho AI.

NVIDIA L40S

NVIDIA L40S là dòng GPU trung tâm dữ liệu tối ưu cho AI inference và đồ họa chuyên nghiệp. Đây là lựa chọn cân bằng giữa hiệu suất AI và khả năng xử lý hình ảnh, video.

Tối ưu cho AI inference

Khác với GPU chuyên training như A100 hoặc H100, L40S tập trung vào:

- Triển khai mô hình AI sau khi đã huấn luyện

- Xử lý yêu cầu AI thời gian thực

- Ứng dụng AI trong doanh nghiệp

Đồ họa chuyên nghiệp và mô phỏng

Ngoài AI, L40S còn mạnh trong:

- Render 3D

- Dựng phim và VFX

- Digital Twin

- Thiết kế sản phẩm

Vì vậy, L40S thường được sử dụng trong máy chủ GPU NVIDIA dành cho studio, công ty thiết kế và doanh nghiệp công nghiệp.

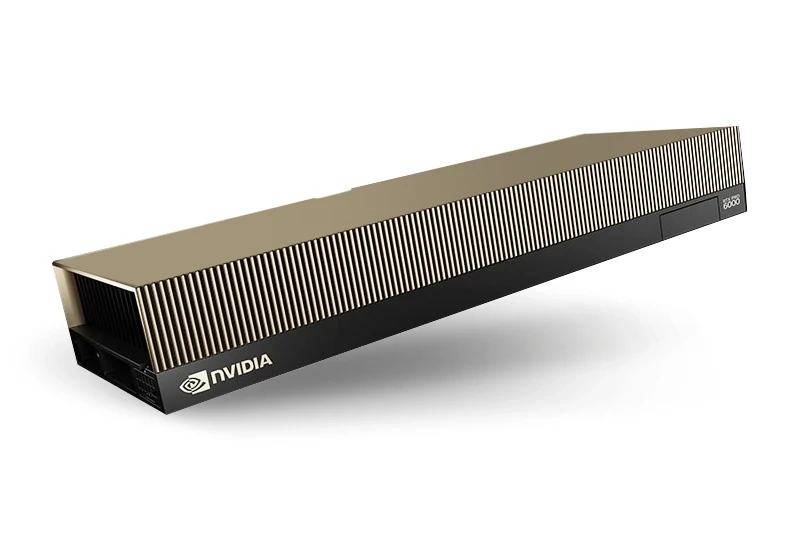

NVIDIA RTX 6000 Ada

NVIDIA RTX 6000 Ada là GPU thuộc phân khúc workstation cao cấp, nhưng vẫn được tích hợp trong các máy chủ GPU cho doanh nghiệp vừa và nhỏ.

Phù hợp cho doanh nghiệp vừa và nhỏ

RTX 6000 Ada cung cấp:

- Hiệu năng AI mạnh mẽ

- Chi phí đầu tư thấp hơn so với dòng data center chuyên dụng

- Dễ triển khai trong hệ thống server tùy chỉnh

Ứng dụng AI, thiết kế 3D và dựng phim

RTX 6000 Ada phù hợp cho:

- Huấn luyện và fine-tuning mô hình AI cỡ trung

- Thiết kế kiến trúc, cơ khí

- Render 3D, dựng phim, sản xuất nội dung

Nhờ sự linh hoạt và hiệu năng ổn định, dòng GPU này mang lại giải pháp cân bằng giữa chi phí và sức mạnh tính toán.

6. Ứng dụng thực tế của máy chủ GPU NVIDIA

Trong kỷ nguyên dữ liệu lớn và trí tuệ nhân tạo, máy chủ GPU NVIDIA không chỉ là hạ tầng phần cứng, mà còn là nền tảng cốt lõi cho nhiều lĩnh vực công nghệ hiện đại. Nhờ khả năng xử lý song song mạnh mẽ, server GPU cho AI giúp doanh nghiệp rút ngắn thời gian tính toán, tăng hiệu suất vận hành và mở rộng quy mô ứng dụng dễ dàng.

Trí tuệ nhân tạo (AI) và Machine Learning

AI và Machine Learning là lĩnh vực ứng dụng phổ biến nhất của máy chủ deep learning sử dụng GPU NVIDIA.

Training mô hình lớn

Huấn luyện mô hình AI đòi hỏi thực hiện hàng tỷ phép tính ma trận và tensor. GPU NVIDIA được thiết kế tối ưu cho loại tác vụ này nhờ:

- Hàng nghìn lõi xử lý song song

- Tensor Cores chuyên biệt cho AI

- Bộ nhớ băng thông cao

Các dòng GPU trung tâm dữ liệu như NVIDIA H100 hay NVIDIA A100 thường được sử dụng để huấn luyện:

- Mô hình ngôn ngữ lớn (LLM)

- Hệ thống nhận diện hình ảnh

- Mô hình dự đoán tài chính

- AI trong y tế và sản xuất

Fine-tuning LLM

Sau khi mô hình lớn được huấn luyện, doanh nghiệp thường cần tinh chỉnh (fine-tune) theo dữ liệu riêng. Máy chủ GPU NVIDIA cho phép:

- Tùy chỉnh chatbot AI nội bộ

- Huấn luyện mô hình hỗ trợ khách hàng

- Phát triển AI chuyên ngành (luật, y tế, fintech)

Điều này giúp doanh nghiệp kiểm soát dữ liệu tốt hơn thay vì phụ thuộc hoàn toàn vào nền tảng cloud bên ngoài.

Deep Learning

Deep learning là nhánh nâng cao của AI, nơi GPU thể hiện rõ nhất lợi thế so với CPU truyền thống.

Computer Vision

Trong lĩnh vực thị giác máy tính, máy chủ GPU NVIDIA được sử dụng để:

- Nhận diện khuôn mặt

- Phân tích hình ảnh y tế

- Giám sát an ninh thông minh

- Kiểm tra lỗi sản phẩm trong sản xuất

NLP (Xử lý ngôn ngữ tự nhiên)

GPU NVIDIA đóng vai trò quan trọng trong:

- Phân tích văn bản

- Dịch máy

- Phân tích cảm xúc khách hàng

- Tóm tắt nội dung tự động

Các mô hình NLP hiện đại yêu cầu tài nguyên tính toán lớn, khiến server GPU cho AI trở thành lựa chọn gần như bắt buộc.

Generative AI

Generative AI là xu hướng nổi bật hiện nay, bao gồm:

- Tạo nội dung văn bản

- Sinh hình ảnh AI

- Tạo video tự động

- Thiết kế sản phẩm bằng AI

Những ứng dụng này yêu cầu GPU hiệu năng cao và khả năng mở rộng đa GPU trong cùng hệ thống, điều mà máy chủ AI NVIDIA đáp ứng rất tốt.

Big Data & Phân tích dữ liệu

Không chỉ dành cho AI, máy chủ GPU NVIDIA còn được sử dụng rộng rãi trong xử lý dữ liệu lớn.

Xử lý dữ liệu thời gian thực

Trong lĩnh vực tài chính, thương mại điện tử và viễn thông, doanh nghiệp cần:

- Phân tích giao dịch tức thời

- Phát hiện gian lận

- Đưa ra gợi ý sản phẩm theo thời gian thực

Phân tích dự đoán

Doanh nghiệp sử dụng máy chủ deep learning để xây dựng mô hình dự đoán:

- Xu hướng thị trường

- Hành vi khách hàng

- Rủi ro tín dụng

- Bảo trì thiết bị

Việc rút ngắn thời gian phân tích giúp doanh nghiệp ra quyết định nhanh và chính xác hơn.

Rendering, 3D, Media & Simulation

Bên cạnh AI, GPU NVIDIA còn được ứng dụng mạnh mẽ trong đồ họa và mô phỏng.

Dựng phim, VFX

Trong ngành điện ảnh và sản xuất nội dung số, GPU hỗ trợ:

- Render 3D

- Tạo hiệu ứng hình ảnh (VFX)

- Xử lý video độ phân giải cao

Các studio lớn thường triển khai server GPU NVIDIA để tối ưu tốc độ dựng phim và giảm thời gian chờ render.

Digital Twin

Digital Twin (bản sao kỹ thuật số) được sử dụng trong:

- Nhà máy thông minh

- Mô phỏng thành phố

- Quản lý hệ thống năng lượng

GPU giúp mô phỏng môi trường ảo với độ chi tiết cao và khả năng tính toán phức tạp.

Mô phỏng khoa học

Trong nghiên cứu khoa học, máy chủ GPU NVIDIA hỗ trợ:

- Mô phỏng khí hậu

- Tính toán vật lý hạt

- Nghiên cứu sinh học phân tử

- Thiết kế vật liệu mới

Khả năng xử lý song song giúp rút ngắn đáng kể thời gian nghiên cứu và thử nghiệm.

7. Kinh nghiệm lựa chọn máy chủ GPU NVIDIA phù hợp

Việc đầu tư máy chủ GPU NVIDIA là quyết định quan trọng vì chi phí không nhỏ và ảnh hưởng trực tiếp đến hiệu suất AI, khả năng mở rộng cũng như ROI dài hạn của doanh nghiệp. Để lựa chọn đúng server GPU NVIDIA, bạn cần đánh giá kỹ nhu cầu thực tế thay vì chỉ chọn cấu hình mạnh nhất.

Chọn GPU theo workload thực tế

Không phải mọi hệ thống AI đều cần GPU cao cấp nhất. Việc lựa chọn GPU nên dựa vào loại tác vụ chính:

- AI training quy mô lớn, LLM, HPC → Nên chọn các dòng data center cao cấp như NVIDIA H100 hoặc NVIDIA A100.

- AI inference, triển khai mô hình đã huấn luyện → Có thể cân nhắc các GPU tối ưu cho inference như NVIDIA L40S.

Startup AI, doanh nghiệp vừa và nhỏ, workload trung bình → GPU workstation như NVIDIA RTX 6000 Ada là lựa chọn cân bằng giữa hiệu năng và chi phí.

Việc xác định rõ mục tiêu (training hay inference, quy mô dữ liệu lớn hay nhỏ) sẽ giúp tối ưu ngân sách và tránh lãng phí tài nguyên.

Xác định dung lượng VRAM phù hợp

VRAM (Video RAM) đóng vai trò cực kỳ quan trọng trong máy chủ deep learning. Nếu VRAM không đủ, mô hình AI sẽ không thể huấn luyện hoặc phải chia nhỏ batch size, làm giảm hiệu suất.

Khi lựa chọn dung lượng VRAM, cần xem xét:

- Kích thước mô hình (số tham số)

- Batch size mong muốn

- Khối lượng dữ liệu đầu vào

- Nhu cầu xử lý đa mô hình song song

Ví dụ:

- Mô hình AI cỡ trung có thể cần 24–48GB VRAM.

- Mô hình ngôn ngữ lớn (LLM) có thể yêu cầu 80GB VRAM hoặc kết nối đa GPU thông qua NVLink.

- Lựa chọn đúng VRAM giúp server GPU cho AI hoạt động ổn định và khai thác tối đa hiệu suất phần cứng.

Băng thông và khả năng mở rộng đa GPU

Trong môi trường doanh nghiệp, nhu cầu tính toán thường tăng theo thời gian. Vì vậy, khi đầu tư máy chủ GPU NVIDIA, cần quan tâm đến:

- Số lượng khe cắm GPU (PCIe)

- Hỗ trợ NVLink giữa các GPU

- Khả năng mở rộng thêm GPU trong tương lai

- Băng thông bộ nhớ và tốc độ truyền dữ liệu nội bộ

Hệ thống có khả năng mở rộng tốt sẽ giúp doanh nghiệp:

- Tăng số GPU khi workload tăng

- Triển khai cụm AI (AI cluster)

- Huấn luyện mô hình lớn hơn mà không cần thay toàn bộ hạ tầng

Đây là yếu tố quan trọng để đảm bảo tính bền vững và tối ưu chi phí dài hạn.

Hệ thống tản nhiệt và nguồn điện

GPU trung tâm dữ liệu có mức tiêu thụ điện năng và nhiệt lượng cao. Nếu hệ thống tản nhiệt không đủ tốt, hiệu suất sẽ bị giảm do throttling hoặc thậm chí gây lỗi phần cứng.

Khi lựa chọn máy chủ AI NVIDIA, cần kiểm tra:

- Công suất nguồn (PSU) phù hợp với tổng TDP GPU

- Thiết kế airflow trong rack server

- Hệ thống làm mát (air cooling hoặc liquid cooling)

- Điều kiện hạ tầng phòng máy (nhiệt độ, độ ẩm)

Một hệ thống được thiết kế chuẩn data center sẽ giúp máy chủ GPU NVIDIA hoạt động ổn định 24/7.

Lựa chọn nhà cung cấp uy tín

Cuối cùng, nhà cung cấp đóng vai trò quan trọng không kém cấu hình phần cứng. Một đơn vị uy tín sẽ:

- Tư vấn cấu hình phù hợp với workload

- Cung cấp giải pháp tối ưu chi phí

- Hỗ trợ kỹ thuật và bảo hành dài hạn

- Có kinh nghiệm triển khai hạ tầng AI thực tế

Khi chọn đối tác triển khai server GPU NVIDIA, doanh nghiệp nên ưu tiên đơn vị có:

- Kinh nghiệm về hạ tầng AI và HPC

- Đội ngũ kỹ sư chuyên sâu

- Khả năng tích hợp hệ thống tổng thể (CPU, storage, network)

Kết luận

Trong bối cảnh AI, Big Data và Generative AI phát triển mạnh mẽ, máy chủ GPU NVIDIA đã trở thành hạ tầng chiến lược của nhiều doanh nghiệp và trung tâm dữ liệu. Nhờ khả năng xử lý song song vượt trội, hệ sinh thái CUDA toàn diện và các dòng GPU hiệu năng cao từ NVIDIA, server GPU NVIDIA giúp rút ngắn thời gian huấn luyện mô hình, tối ưu chi phí vận hành và nâng cao năng lực cạnh tranh.

Dù bạn là startup AI, doanh nghiệp đang chuyển đổi số hay tổ chức nghiên cứu cần tính toán hiệu năng cao, việc đầu tư đúng máy chủ AI NVIDIA sẽ tạo nền tảng vững chắc cho sự phát triển lâu dài. Từ training mô hình deep learning, triển khai LLM, phân tích dữ liệu lớn đến mô phỏng khoa học và rendering 3D, GPU NVIDIA đang định hình tiêu chuẩn mới cho hạ tầng công nghệ hiện đại.