Máy chủ Server GPU NVIDIA H200

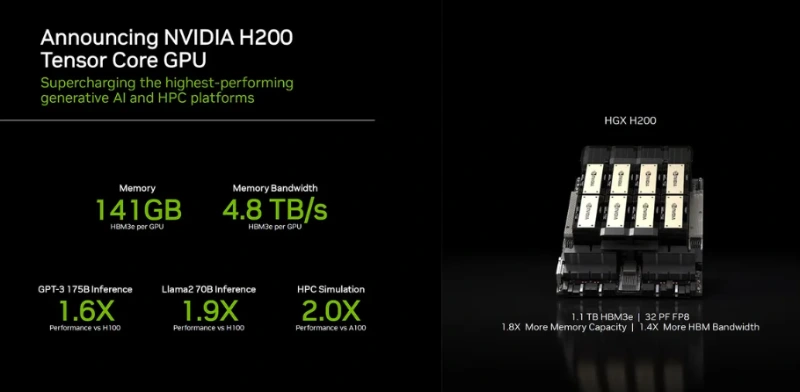

NVIDIA H200 Tensor Core GPU là bước đột phá mới dựa trên kiến trúc Hopper, chuyên dụng cho AI và HPC. Đây là GPU đầu tiên sở hữu bộ nhớ HBM3e 141GB với băng thông cực đại 4.8TB/s, nhanh hơn 1.4 lần so với H100. H200 mang lại hiệu suất suy luận AI gấp 2 lần, giúp xử lý các mô hình ngôn ngữ lớn (LLM) vượt trội. Nhờ khả năng tương thích hoàn hảo với hạ tầng HGX H100, H200 là giải pháp tối ưu để tăng tốc các trung tâm dữ liệu, tiết kiệm năng lượng và giảm tổng chi phí sở hữu.

Trong làn sóng cách mạng công nghiệp 4.0, trí tuệ nhân tạo tạo năng (Generative AI) và các mô hình ngôn ngữ lớn (LLM) đã trở thành trọng tâm của sự đổi mới. Tuy nhiên, để vận hành những mô hình có hàng tỷ tham số, các trung tâm dữ liệu đòi hỏi một sức mạnh tính toán vượt xa những gì chúng ta từng hình dung. Để đáp trả thách thức đó, NVIDIA đã giới thiệu H200 Tensor Core GPU – một bước nhảy vọt so với người tiền nhiệm H100, thiết lập nên những tiêu chuẩn mới về bộ nhớ, băng thông và hiệu suất thực thi.

1. Sự Kế Thừa Và Đột Phá Từ Kiến Trúc Hopper

NVIDIA H200 không chỉ là một bản cập nhật nhỏ; nó là sự tinh chỉnh đỉnh cao của kiến trúc NVIDIA Hopper™. Trong khi H100 đã thống trị thị trường AI, H200 xuất hiện để giải quyết bài toán lớn nhất hiện nay: Điểm nghẽn bộ nhớ.

H200 là GPU đầu tiên trên thế giới được trang bị công nghệ bộ nhớ HBM3e (High Bandwidth Memory 3e). Đây là chìa khóa để mở ra khả năng xử lý các khối lượng công việc khổng lồ, nơi mà dữ liệu cần được nạp và truy xuất với tốc độ ánh sáng để giữ cho các nhân Tensor luôn hoạt động ở công suất tối đa.

2. Thông Số Kỹ Thuật Ấn Tượng: Phá Vỡ Mọi Rào Cản Bộ Nhớ

Điểm khác biệt lớn nhất và quan trọng nhất của H200 chính là cấu hình bộ nhớ:

Dung lượng bộ nhớ khổng lồ: H200 sở hữu tới 141GB bộ nhớ HBM3e. So với 80GB trên H100, đây là một sự gia tăng gần gấp đôi. Việc có thêm dung lượng cho phép các mô hình ngôn ngữ lớn nhất hiện nay có thể nằm gọn trong bộ nhớ GPU, giảm thiểu việc phải hoán đổi dữ liệu giữa các GPU hoặc với CPU, từ đó tăng tốc độ xử lý đáng kể.

Băng thông bộ nhớ siêu tốc: Tốc độ truyền tải dữ liệu đạt tới 4.8 Terabytes mỗi giây (TB/s). Để dễ hình dung, con số này nhanh hơn 1.4 lần so với H100 (vốn đã rất nhanh với 3.35 TB/s). Băng thông cực cao này đảm bảo rằng các nhân xử lý không bao giờ phải “đứng đợi” dữ liệu, giúp tối ưu hóa hiệu suất tính toán thực tế.

3. Hiệu Suất Thực Tế: Sức Mạnh Gấp Đôi Trong Suy Luận AI

Mục tiêu cuối cùng của H200 là mang lại kết quả nhanh hơn cho người dùng cuối. Theo các thử nghiệm của NVIDIA, H200 mang lại hiệu suất vượt trội trong các tác vụ then chốt:

Suy luận AI (AI Inference)

Với các mô hình như Llama2 70B, H200 cho khả năng suy luận nhanh gấp 2 lần so với H100. Điều này có nghĩa là các ứng dụng chatbot, dịch thuật trực tiếp hoặc tạo nội dung tự động sẽ phản hồi nhanh hơn, xử lý được nhiều yêu cầu của người dùng hơn trên cùng một hạ tầng phần cứng.

Đào tạo AI (AI Training)

Mặc dù H100 vẫn là một “quái vật” trong đào tạo, nhưng dung lượng bộ nhớ lớn của H200 cho phép huấn luyện các mô hình lớn hơn với kích thước lô (batch size) lớn hơn, giúp rút ngắn thời gian hội tụ của mô hình và tối ưu hóa tài nguyên hệ thống.

Điện toán hiệu năng cao (HPC)

Trong các lĩnh vực khoa học như dự báo thời tiết, mô phỏng động lực học chất lưu hay nghiên cứu vật liệu, băng thông bộ nhớ của H200 giúp tăng tốc các phép tính phức tạp, đưa các nghiên cứu khoa học tiến gần hơn tới kết quả thực tiễn với độ chính xác cao hơn.

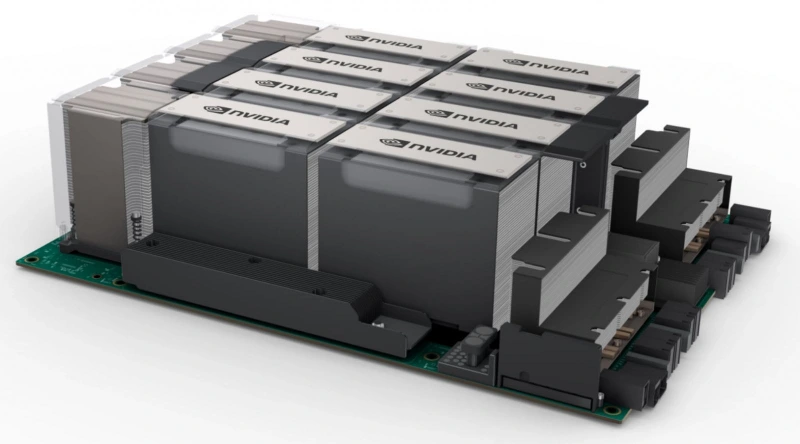

4. Khả Năng Tương Thích Và Tối Ưu Hóa Hệ Thống

Một ưu điểm chiến lược của H200 là tính tương thích. NVIDIA đã thiết kế H200 để có thể lắp đặt vào các hệ thống NVIDIA HGX™ H100 hiện có.

Nâng cấp dễ dàng: Các doanh nghiệp và nhà cung cấp dịch vụ đám mây (CSP) không cần phải thiết kế lại toàn bộ trung tâm dữ liệu. Họ có thể sử dụng cùng một cấu trúc bo mạch chủ, cùng một hệ thống làm mát và nguồn điện để nâng cấp lên H200.

Hệ sinh thái phần mềm toàn diện: H200 tận dụng toàn bộ sức mạnh của nền tảng NVIDIA AI Enterprise. Với các thư viện như TensorRT-LLM, các mô hình AI sẽ tự động được tối ưu hóa để tận dụng tối đa lượng bộ nhớ và băng thông dồi dào trên H200 mà không cần lập trình lại từ đầu.

5. Hiệu Quả Năng Lượng Và Tối Ưu Chi Phí (TCO)

Trong bối cảnh chi phí năng lượng và diện tích trung tâm dữ liệu ngày càng đắt đỏ, H200 mang lại một giá trị kinh tế bền vững. Bằng cách cung cấp hiệu suất gấp đôi trên cùng một mức tiêu thụ điện năng so với việc phải lắp đặt thêm nhiều GPU thế hệ cũ, H200 giúp giảm đáng kể tổng chi phí sở hữu (Total Cost of Ownership – TCO). Các doanh nghiệp có thể đạt được mục tiêu tính toán của mình với ít máy chủ hơn, ít điện năng hơn và ít không gian hơn.

6. Tầm Nhìn Tương Lai: Nền Tảng Cho AI Exascale

NVIDIA H200 không chỉ là một sản phẩm phần cứng; nó là lời cam kết của NVIDIA trong việc thúc đẩy giới hạn của trí tuệ nhân tạo. Khi kết hợp với công nghệ kết nối NVLink và NVSwitch, hàng ngàn GPU H200 có thể liên kết lại tạo thành một siêu máy tính AI khổng lồ, sẵn sàng chinh phục những mô hình AI có hàng nghìn tỷ tham số trong tương lai.

Tổng Kết

NVIDIA H200 Tensor Core GPU chính là chiếc chìa khóa vạn năng cho các doanh nghiệp đang khao khát dẫn đầu trong cuộc đua AI. Với bộ nhớ HBM3e 141GB và băng thông 4.8TB/s, H200 không chỉ giải quyết triệt để các hạn chế về dữ liệu mà còn mang lại hiệu suất thực thi kinh ngạc, biến những ý tưởng AI táo bạo nhất thành hiện thực chỉ trong tích tắc.