Máy Chủ Deep Learning Là Gì? Hướng Dẫn Chọn Cấu Hình Tối Ưu 2026

Bạn đã bao giờ tự hỏi làm thế nào ChatGPT có thể làm thơ, hay cách các hệ thống xe tự lái nhận diện vật cản trong tích tắc? Đằng sau những phép màu đó không phải là những chiếc máy tính văn phòng thông thường, mà là các Máy chủ Deep Learning (Deep Learning Servers) – những hệ thống tính toán siêu cấp được thiết kế chỉ để làm một việc duy nhất: Học.

Trong bài viết này, chúng ta sẽ cùng “mổ xẻ” cấu tạo, sức mạnh và lý do vì sao máy chủ Deep Learning lại là linh kiện đắt đỏ và được săn đón nhất hiện nay.

1. Máy Chủ Deep Learning Là Gì?

Máy chủ deep learning là một hệ thống máy chủ chuyên dụng được thiết kế để xử lý các tác vụ tính toán phức tạp trong lĩnh vực Trí tuệ nhân tạo (AI) và Machine Learning.

Trong các dự án AI hiện đại, dữ liệu thường có kích thước rất lớn và mô hình deep learning có thể chứa hàng triệu đến hàng tỷ tham số. Việc huấn luyện những mô hình này đòi hỏi:

- Khả năng xử lý song song mạnh mẽ (parallel computing)

- Tốc độ truyền dữ liệu cao

- Bộ nhớ đủ lớn để lưu trữ dataset và trọng số mô hình

Đây chính là lý do server AI đóng vai trò trung tâm trong:

- Huấn luyện mô hình Computer Vision (nhận diện hình ảnh, video)

- Xử lý ngôn ngữ tự nhiên (NLP)

- Phân tích dữ liệu lớn (Big Data Analytics)

- Phát triển chatbot AI và hệ thống đề xuất

2. Vì Sao Deep Learning Cần Máy Chủ Chuyên Dụng?

Deep learning không chỉ là việc chạy một vài thuật toán thông thường. Đây là quá trình huấn luyện các mô hình có cấu trúc phức tạp, sử dụng khối lượng dữ liệu khổng lồ và yêu cầu năng lực tính toán cực cao. Vì vậy, máy chủ deep learning được thiết kế riêng để đáp ứng những yêu cầu này, thay vì sử dụng máy tính phổ thông.

Dưới đây là ba lý do quan trọng giải thích vì sao deep learning cần một máy chủ AI chuyên dụng.

Khối Lượng Tính Toán Cực Lớn

Trong deep learning, việc training mô hình như CNN (Convolutional Neural Network) cho nhận diện hình ảnh hoặc Transformer cho xử lý ngôn ngữ tự nhiên đòi hỏi hàng tỷ phép tính toán mỗi giây.

Một mô hình học sâu hiện đại có thể chứa:

- Hàng triệu đến hàng tỷ tham số

- Nhiều tầng mạng (layers) phức tạp

- Quá trình lan truyền xuôi (forward propagation) và lan truyền ngược (backpropagation) liên tục

Nếu sử dụng máy tính thông thường, thời gian training có thể kéo dài hàng tuần hoặc thậm chí hàng tháng. Trong khi đó, server deep learning với kiến trúc tối ưu có thể rút ngắn đáng kể thời gian huấn luyện, giúp doanh nghiệp tăng tốc phát triển sản phẩm AI và giảm chi phí vận hành.

Yêu Cầu GPU Hiệu Năng Cao

Thành phần quan trọng nhất của một máy chủ AI chính là GPU. Deep learning tận dụng khả năng tính toán song song (parallel computing) để xử lý hàng nghìn phép toán đồng thời.

GPU chuyên dụng cho deep learning thường sở hữu:

- Hàng nghìn CUDA cores

- Tensor cores tối ưu cho phép tính ma trận

- Dung lượng VRAM lớn để lưu trữ mô hình và dữ liệu

Nhờ đó, GPU có thể tăng tốc quá trình training lên nhiều lần so với CPU. Một hệ thống máy chủ deep learning đa GPU còn cho phép mở rộng hiệu năng theo nhu cầu, phù hợp cho các dự án AI quy mô lớn.

Xử Lý Dữ Liệu Lớn (Big Data)

Deep learning hoạt động hiệu quả nhất khi được huấn luyện trên tập dữ liệu lớn. Trong thực tế, dataset có thể đạt kích thước từ vài terabyte (TB) đến petabyte (PB), đặc biệt trong các lĩnh vực như:

- Computer Vision

- Phân tích video

- NLP và chatbot AI

- Phân tích dữ liệu doanh nghiệp

Điều này đòi hỏi server AI phải có:

- Ổ cứng SSD NVMe tốc độ cao

- Băng thông truyền dữ liệu lớn

- Hệ thống lưu trữ ổn định và đáng tin cậy

Nếu tốc độ đọc/ghi chậm, GPU sẽ bị “nghẽn cổ chai” (bottleneck) do không được cung cấp dữ liệu kịp thời. Vì vậy, một máy chủ deep learning chuyên dụng cần được tối ưu đồng bộ giữa GPU, CPU, RAM và hệ thống lưu trữ để đảm bảo hiệu suất tối đa.

3. Cấu Hình Máy Chủ Deep Learning Gồm Những Gì?

Để xây dựng một máy chủ deep learning mạnh mẽ và ổn định, bạn cần tối ưu đồng bộ nhiều thành phần phần cứng. Khác với server thông thường, server AI không chỉ tập trung vào CPU mà đặc biệt nhấn mạnh vào GPU, RAM dung lượng lớn và hệ thống lưu trữ tốc độ cao. Dưới đây là các thành phần quan trọng nhất trong cấu hình máy chủ deep learning.

GPU

Trong mọi hệ thống máy chủ AI, GPU là trung tâm của sức mạnh tính toán. Deep learning dựa vào khả năng xử lý song song (parallel computing) để thực hiện hàng triệu phép toán ma trận mỗi giây – điều mà GPU làm tốt hơn CPU rất nhiều.

Dung lượng VRAM quyết định kích thước mô hình và batch size bạn có thể huấn luyện:

- 24GB VRAM: Phù hợp cho nghiên cứu cá nhân, mô hình CNN hoặc NLP tầm trung

- 48GB VRAM: Tốt cho startup AI hoặc training mô hình lớn hơn

- 80GB VRAM trở lên: Dành cho doanh nghiệp, mô hình Transformer lớn hoặc LLM

Nếu VRAM không đủ, bạn sẽ phải giảm batch size hoặc chia nhỏ mô hình, làm tăng thời gian training. Vì vậy, khi chọn GPU cho máy chủ deep learning, nên ưu tiên dư VRAM để đảm bảo khả năng mở rộng lâu dài.

Một ưu điểm lớn của server deep learning là khả năng chạy nhiều GPU cùng lúc (2, 4, 8 GPU hoặc hơn). Multi-GPU giúp:

- Tăng tốc training đáng kể

- Chia tải xử lý dữ liệu

- Phù hợp cho mô hình AI quy mô lớn

Tuy nhiên, để scaling hiệu quả, cần đảm bảo bo mạch chủ, nguồn điện và băng thông PCIe đủ mạnh.

CPU

Mặc dù GPU xử lý phần lớn tác vụ tính toán, CPU vẫn đóng vai trò quan trọng trong một máy chủ deep learning.

CPU chịu trách nhiệm:

- Tiền xử lý dữ liệu (data preprocessing)

- Load dataset

- Điều phối GPU

Với server AI, nên chọn CPU có nhiều nhân và luồng (tối thiểu 16–32 cores cho hệ thống đa GPU). Điều này giúp tránh tình trạng CPU không kịp cung cấp dữ liệu cho GPU.

Nếu CPU quá yếu so với GPU, hệ thống sẽ gặp “nghẽn cổ chai” (bottleneck). GPU có thể hoạt động dưới công suất do chờ dữ liệu. Vì vậy, cấu hình máy chủ AI chuyên dụng cần cân bằng giữa CPU và GPU để tối ưu hiệu năng tổng thể.

RAM

RAM đóng vai trò lưu trữ dữ liệu tạm thời, batch training và xử lý song song.

Bao Nhiêu GB Cho Training Lớn?

- 64GB RAM: Phù hợp cho dự án nhỏ

- 128GB – 256GB RAM: Tối ưu cho training mô hình lớn

- 512GB trở lên: Dành cho hệ thống AI doanh nghiệp

Dung lượng RAM càng lớn, khả năng xử lý dataset lớn càng mượt mà.

ECC RAM (Error-Correcting Code) giúp phát hiện và sửa lỗi bộ nhớ. Trong môi trường server deep learning chạy 24/7, ECC RAM rất quan trọng để đảm bảo độ ổn định và tránh lỗi làm hỏng quá trình training kéo dài nhiều ngày.

Lưu Trữ (Storage)

Tốc độ lưu trữ ảnh hưởng trực tiếp đến hiệu suất của máy chủ deep learning, đặc biệt khi làm việc với dataset lớn.

- SSD NVMe: Tốc độ đọc/ghi cực cao, lý tưởng cho training AI

- SSD SATA: Ổn định nhưng chậm hơn NVMe

- HDD: Phù hợp lưu trữ dữ liệu backup, không nên dùng cho training trực tiếp

Trong cấu hình server AI, nên dùng NVMe làm ổ chính chứa dataset và môi trường training.

RAID giúp:

- Tăng tốc độ đọc/ghi (RAID 0)

- Tăng độ an toàn dữ liệu (RAID 1, RAID 5, RAID 10)

Với máy chủ AI doanh nghiệp, RAID 10 thường được lựa chọn để cân bằng giữa hiệu năng và bảo mật dữ liệu.

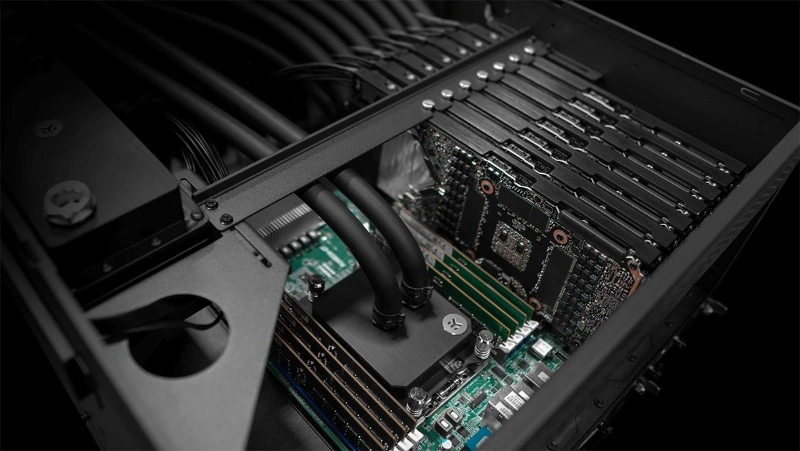

Nguồn Điện Và Hệ Thống Tản Nhiệt

Đây là yếu tố thường bị bỏ qua nhưng cực kỳ quan trọng trong server deep learning đa GPU.

Mỗi GPU cao cấp có thể tiêu thụ từ 250W đến 700W. Một hệ thống 4 GPU có thể yêu cầu nguồn trên 2000W. Vì vậy:

- Chọn PSU công suất dư ít nhất 20–30%

- Ưu tiên nguồn đạt chuẩn Platinum hoặc Titanium

Hệ Thống Làm Mát Chuyên Dụng

Máy chủ deep learning thường hoạt động liên tục 24/7. Nếu không có hệ thống làm mát tốt:

- GPU có thể giảm xung nhịp (thermal throttling)

- Giảm tuổi thọ linh kiện

Các giải pháp phổ biến gồm:

- Hệ thống quạt hiệu suất cao

- Làm mát bằng nước (liquid cooling)

- Tủ rack chuyên dụng cho datacenter

4. GPU Nào Tốt Nhất Cho Máy Chủ Deep Learning?

Khi xây dựng máy chủ deep learning, việc lựa chọn GPU phù hợp là yếu tố quan trọng nhất quyết định hiệu năng training và khả năng mở rộng hệ thống. Không phải mọi GPU đều giống nhau – mỗi dòng sẽ phù hợp với từng mục tiêu khác nhau như nghiên cứu, startup AI hay triển khai ở quy mô doanh nghiệp.

Dưới đây là phân tích chi tiết giúp bạn chọn đúng GPU deep learning cho hệ thống của mình.

GPU Chuyên Dụng Cho AI

Trong môi trường doanh nghiệp và datacenter, các dòng GPU chuyên dụng cho AI luôn là lựa chọn hàng đầu. Tiêu biểu là dòng NVIDIA A100 và NVIDIA H100 – những GPU được thiết kế riêng cho deep learning và AI server.

Dòng NVIDIA A Series

GPU thuộc A Series (như A100) thường có:

- VRAM lớn (40GB – 80GB hoặc hơn)

- Tensor Cores tối ưu cho phép tính ma trận

- Hỗ trợ NVLink để kết nối đa GPU tốc độ cao

- Khả năng hoạt động ổn định 24/7 trong datacenter

Đây là lựa chọn lý tưởng cho:

- Training mô hình Transformer lớn

- Huấn luyện LLM

- Hệ thống AI doanh nghiệp

GPU Datacenter

GPU datacenter được tối ưu cho GPU AI server, với các lợi thế:

- ECC memory chống lỗi

- Hiệu năng ổn định khi tải cao

- Hỗ trợ ảo hóa và multi-instance GPU (MIG)

- Khả năng mở rộng nhiều GPU trong cùng một rack server

Nhược điểm lớn nhất là chi phí đầu tư ban đầu rất cao. Tuy nhiên, với doanh nghiệp triển khai AI quy mô lớn, đây là khoản đầu tư cần thiết để đảm bảo hiệu suất và độ tin cậy.

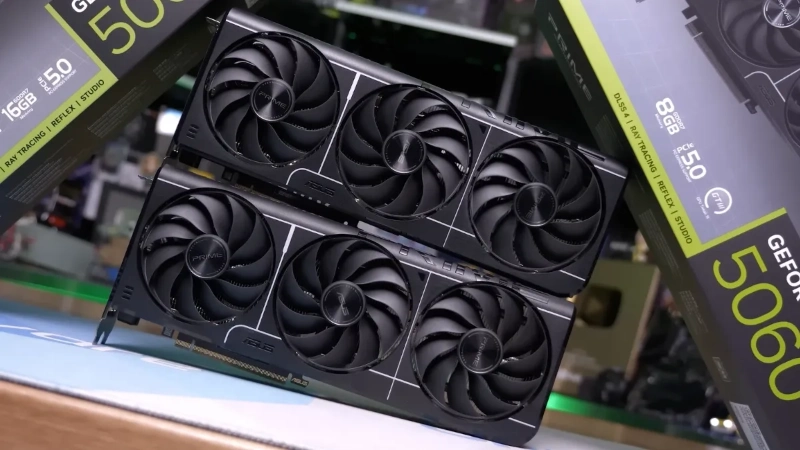

GPU Consumer Có Dùng Được Không?

Câu trả lời là: Có, trong nhiều trường hợp.

Các dòng GPU consumer như NVIDIA GeForce RTX 4090 hay NVIDIA GeForce RTX 4080 vẫn có thể sử dụng hiệu quả cho deep learning, đặc biệt ở quy mô nhỏ đến trung bình.

RTX Series

GPU RTX sở hữu:

- Số lượng CUDA cores lớn

- Tensor cores hỗ trợ AI

- VRAM 16GB – 24GB (hoặc hơn)

- Giá thành thấp hơn nhiều so với GPU datacenter

Đây là giải pháp tối ưu cho:

- Nghiên cứu cá nhân

- Sinh viên AI

- Startup AI giai đoạn đầu

Ưu Và Nhược Điểm

Ưu điểm:

- Giá/hiệu năng rất tốt

- Dễ mua và dễ build hệ thống

- Phù hợp cho workstation hoặc server nhỏ

Nhược điểm:

- Không có ECC memory

- Không tối ưu cho vận hành 24/7 dài hạn

- Khả năng mở rộng multi-GPU hạn chế hơn so với GPU datacenter

So Sánh GPU Theo Nhu Cầu

Việc chọn GPU AI server nên dựa vào quy mô dự án và ngân sách.

1. Research Và Cá Nhân

- RTX 4080 / 4090

- 1–2 GPU là đủ

- Phù hợp CNN, NLP cỡ vừa

- Chi phí thấp, hiệu năng cao, dễ triển khai.

2. Startup AI

- 2–4 GPU RTX cao cấp hoặc 1 GPU datacenter

- VRAM lớn để huấn luyện mô hình phức tạp

- Cần cân bằng giữa chi phí và khả năng mở rộng

3. Doanh Nghiệp Lớn

- A100, H100 hoặc GPU datacenter tương đương

- 4–8 GPU trở lên

- Hạ tầng rack server, NVLink, hệ thống làm mát chuyên dụng

Ở quy mô này, hiệu năng, độ ổn định và khả năng mở rộng quan trọng hơn chi phí phần cứng ban đầu.

5. Cách Chọn Máy Chủ Deep Learning Theo Nhu Cầu

Việc lựa chọn máy chủ deep learning không nên dựa chỉ vào cấu hình mạnh nhất, mà cần căn cứ vào mục tiêu sử dụng thực tế. Mỗi nhóm người dùng – từ cá nhân nghiên cứu đến doanh nghiệp triển khai AI quy mô lớn – sẽ có yêu cầu khác nhau về hiệu năng, khả năng mở rộng và ngân sách.

Dưới đây là hướng dẫn chi tiết giúp bạn chọn server AI phù hợp với từng nhu cầu cụ thể.

Cho Cá Nhân Nghiên Cứu

Nếu bạn là sinh viên, researcher hoặc kỹ sư AI làm việc với các mô hình vừa và nhỏ, bạn không nhất thiết phải đầu tư hệ thống quá phức tạp.

Gợi ý cấu hình máy chủ deep learning cho cá nhân:

- 1–2 GPU RTX VRAM 16GB–24GB

- CPU 16–24 cores

- RAM 64GB–128GB

- SSD NVMe 1TB–2TB

Cấu hình này đủ để:

- Huấn luyện mô hình CNN

- Làm việc với NLP cỡ trung

- Thử nghiệm kiến trúc mới

Ở giai đoạn này, yếu tố quan trọng nhất là giá/hiệu năng. Một máy chủ AI nhỏ gọn hoặc workstation cao cấp có thể đáp ứng tốt nhu cầu nghiên cứu mà vẫn tiết kiệm chi phí.

Cho Startup AI

Startup thường cần huấn luyện mô hình phức tạp hơn, xử lý dataset lớn hơn và yêu cầu thời gian training nhanh để rút ngắn chu kỳ phát triển sản phẩm.

Gợi ý cấu hình server deep learning cho startup:

- 2–4 GPU hiệu năng cao

- VRAM tối thiểu 24GB mỗi GPU

- CPU 32 cores trở lên

- RAM 128GB–256GB

- SSD NVMe tốc độ cao + hệ thống RAID

Ở cấp độ này, khả năng mở rộng (scalability) trở nên quan trọng. Bạn nên chọn máy chủ deep learning có thể nâng cấp thêm GPU hoặc RAM trong tương lai mà không cần thay toàn bộ hệ thống.

Cho Doanh Nghiệp Triển Khai AI Quy Mô Lớn

Doanh nghiệp lớn thường huấn luyện mô hình có hàng trăm triệu đến hàng tỷ tham số, hoặc vận hành nhiều pipeline AI song song.

Yêu cầu của máy chủ AI doanh nghiệp:

- 4–8 GPU datacenter trở lên

- VRAM 40GB–80GB mỗi GPU

- CPU nhiều nhân (dual CPU server)

- RAM 256GB–512GB hoặc hơn

- Hệ thống lưu trữ NVMe tốc độ cao

- RAID và backup dữ liệu

- Hạ tầng rack server chuyên dụng

Ở quy mô này, yếu tố ổn định 24/7 và độ tin cậy quan trọng hơn chi phí phần cứng ban đầu.

Cho Inference Và Triển Khai Production

Không phải mọi hệ thống AI đều cần cấu hình cực mạnh. Nếu mục tiêu của bạn là inference (triển khai mô hình đã huấn luyện), yêu cầu phần cứng sẽ khác so với training.

Đặc điểm máy chủ deep learning cho inference:

- Ít GPU hơn (1–2 GPU có thể đủ)

- Tập trung vào độ ổn định và latency thấp

- CPU đủ mạnh để xử lý request đồng thời

- Tối ưu hóa năng lượng và chi phí vận hành

Trong production, điều quan trọng là:

- Thời gian phản hồi nhanh

- Khả năng xử lý nhiều người dùng cùng lúc

- Tính ổn định và khả năng scale theo traffic

Vì vậy, một server AI cho inference không cần VRAM quá lớn nhưng cần hệ thống mạng và hạ tầng ổn định.

6. Chi Phí Đầu Tư Máy Chủ Deep Learning

Khi triển khai máy chủ deep learning, chi phí đầu tư là yếu tố quan trọng mà cá nhân và doanh nghiệp cần cân nhắc kỹ lưỡng. Tổng ngân sách không chỉ bao gồm giá phần cứng ban đầu, mà còn liên quan đến điện năng, vận hành và lợi tức đầu tư (ROI) trong dài hạn.

Dưới đây là phân tích chi tiết các khoản chi phí khi xây dựng một server AI chuyên dụng.

Giá GPU AI

GPU là thành phần đắt đỏ nhất trong một máy chủ AI. Tùy vào dòng GPU bạn lựa chọn, chi phí có thể dao động rất lớn.

Các GPU datacenter như NVIDIA A100 hoặc NVIDIA H100 thường có giá rất cao do:

- VRAM lớn (40GB–80GB hoặc hơn)

- Tensor Cores tối ưu cho deep learning

- Hỗ trợ multi-GPU và NVLink

- Thiết kế cho vận hành 24/7 trong datacenter

Trong khi đó, các GPU consumer như NVIDIA GeForce RTX 4090 có chi phí thấp hơn đáng kể nhưng vẫn mang lại hiệu năng training rất tốt cho nghiên cứu và startup.

Thông thường:

- GPU consumer: chi phí tối ưu, phù hợp cá nhân và startup

- GPU datacenter: chi phí cao, phù hợp doanh nghiệp lớn

Vì GPU chiếm phần lớn ngân sách, việc lựa chọn đúng loại GPU sẽ ảnh hưởng trực tiếp đến tổng chi phí build server deep learning.

Tổng Chi Phí Build Server Deep Learning

Ngoài GPU, bạn cần tính đến các thành phần khác trong cấu hình:

- CPU nhiều nhân hiệu năng cao

- RAM dung lượng lớn (128GB–512GB)

- SSD NVMe tốc độ cao

- Mainboard hỗ trợ đa GPU

- PSU công suất lớn

- Hệ thống tản nhiệt chuyên dụng

- Vỏ rack server (nếu triển khai trong datacenter)

Tổng chi phí xây dựng máy chủ deep learning có thể dao động rất rộng tùy theo quy mô:

- Hệ thống 1–2 GPU: chi phí vừa phải, phù hợp nghiên cứu

- Hệ thống 4–8 GPU: chi phí cao, dành cho startup AI hoặc doanh nghiệp

- Hệ thống datacenter đa node: đầu tư lớn, dành cho tổ chức triển khai AI quy mô toàn diện

Do đó, trước khi build server AI, bạn nên xác định rõ nhu cầu training, mô hình sử dụng và kế hoạch mở rộng trong tương lai.

Chi Phí Điện Năng Và Vận Hành

Một yếu tố thường bị bỏ qua khi đầu tư server deep learning là điện năng tiêu thụ.

GPU hiệu năng cao có thể tiêu thụ từ vài trăm watt đến gần 700W mỗi chiếc. Một hệ thống 4 GPU có thể tiêu thụ hàng kilowatt điện khi hoạt động tối đa.

Chi phí vận hành bao gồm:

- Tiền điện hàng tháng

- Hệ thống làm mát (điều hòa, quạt công suất cao)

- Bảo trì phần cứng

- Thay thế linh kiện khi cần

Nếu máy chủ AI hoạt động 24/7, tổng chi phí điện năng trong một năm có thể là con số đáng kể. Vì vậy, tối ưu hiệu suất năng lượng và chọn linh kiện đạt chuẩn cao (80 Plus Platinum/Titanium) sẽ giúp tiết kiệm chi phí dài hạn.

ROI Khi Đầu Tư Máy Chủ AI

ROI (Return on Investment) là yếu tố quan trọng nhất khi đánh giá hiệu quả đầu tư máy chủ deep learning.

Việc sở hữu server AI riêng mang lại lợi ích:

- Chủ động tài nguyên tính toán

- Không phụ thuộc vào giá thuê GPU cloud

- Bảo mật dữ liệu tốt hơn

- Tăng tốc độ phát triển sản phẩm AI

Tuy nhiên, nếu nhu cầu training không liên tục hoặc quy mô nhỏ, thuê GPU cloud có thể tối ưu hơn về chi phí ban đầu.

Đối với doanh nghiệp huấn luyện mô hình thường xuyên hoặc vận hành AI dài hạn, đầu tư máy chủ AI chuyên dụng thường mang lại ROI cao nhờ:

- Giảm chi phí thuê cloud lâu dài

- Rút ngắn thời gian training

- Tăng năng suất đội ngũ kỹ thuật

6. Ứng Dụng Thực Tế Của Máy Chủ Deep Learning

Ngày nay, máy chủ deep learning đóng vai trò cốt lõi trong hầu hết các hệ thống AI hiện đại. Nhờ khả năng xử lý song song mạnh mẽ, GPU hiệu năng cao và hạ tầng lưu trữ tối ưu, server AI giúp doanh nghiệp triển khai các ứng dụng trí tuệ nhân tạo ở quy mô lớn, ổn định và liên tục 24/7.

Dưới đây là những ứng dụng thực tế phổ biến nhất của máy chủ deep learning.

Computer Vision (Thị Giác Máy Tính)

Computer Vision là một trong những lĩnh vực sử dụng máy chủ AI nhiều nhất. Các mô hình deep learning trong lĩnh vực này có thể:

- Nhận diện vật thể trong hình ảnh và video

- Phân tích hành vi khách hàng trong bán lẻ

- Kiểm tra lỗi sản phẩm trong nhà máy

Hỗ trợ xe tự lái

Những tác vụ này yêu cầu xử lý hàng nghìn khung hình mỗi giây và training trên dataset lớn (hàng TB dữ liệu). Vì vậy, máy chủ deep learning đa GPU giúp rút ngắn thời gian huấn luyện và tăng tốc độ xử lý hình ảnh theo thời gian thực.

NLP (Xử Lý Ngôn Ngữ Tự Nhiên)

NLP là lĩnh vực phát triển mạnh mẽ trong AI, đặc biệt với sự xuất hiện của các mô hình Transformer và LLM.

Ứng dụng của NLP bao gồm:

- Dịch máy tự động

- Phân tích cảm xúc khách hàng

- Tóm tắt văn bản

- Trích xuất thông tin

Các mô hình NLP hiện đại có thể chứa hàng trăm triệu đến hàng tỷ tham số, đòi hỏi server deep learning có VRAM lớn và khả năng mở rộng nhiều GPU để training hiệu quả. Nếu không có máy chủ AI đủ mạnh, thời gian huấn luyện có thể kéo dài rất lâu và làm chậm tiến độ dự án.

Nhận Diện Khuôn Mặt

Nhận diện khuôn mặt là một ứng dụng quan trọng của máy chủ deep learning trong:

- Hệ thống an ninh

- Kiểm soát ra vào

- Chấm công tự động

- Xác thực danh tính

Hệ thống này yêu cầu:

- Training mô hình chính xác cao

- Xử lý hình ảnh theo thời gian thực

Độ trễ thấp

Với server AI chuyên dụng, doanh nghiệp có thể triển khai hệ thống nhận diện khuôn mặt ổn định, chính xác và mở rộng dễ dàng khi số lượng người dùng tăng lên.

Phân Tích Dữ Liệu Lớn (Big Data Analytics)

Deep learning ngày càng được ứng dụng trong phân tích dữ liệu lớn để:

- Dự đoán xu hướng thị trường

- Phát hiện gian lận tài chính

- Tối ưu chuỗi cung ứng

- Cá nhân hóa trải nghiệm khách hàng

Khối lượng dữ liệu trong các hệ thống này có thể đạt đến hàng terabyte hoặc petabyte. Do đó, máy chủ AI cần có RAM dung lượng lớn, SSD NVMe tốc độ cao và GPU mạnh để xử lý nhanh chóng và chính xác.

Việc đầu tư đúng server deep learning giúp doanh nghiệp khai thác tối đa giá trị từ dữ liệu và đưa ra quyết định dựa trên phân tích AI.

AI Chatbot Và Trợ Lý Ảo

AI chatbot là một trong những ứng dụng phổ biến nhất hiện nay của deep learning. Các doanh nghiệp sử dụng chatbot để:

- Hỗ trợ khách hàng 24/7

- Tự động trả lời câu hỏi

- Thu thập dữ liệu người dùng

- Tối ưu quy trình chăm sóc khách hàng

Để chatbot hoạt động mượt mà và phản hồi nhanh, hệ thống cần máy chủ deep learning cho inference có độ trễ thấp và khả năng xử lý đồng thời nhiều yêu cầu.

Đối với chatbot sử dụng mô hình ngôn ngữ lớn (LLM), việc training và fine-tuning cũng đòi hỏi server AI đa GPU với VRAM lớn và hiệu năng cao.

Kết Luận

Trong kỷ nguyên trí tuệ nhân tạo, máy chủ deep learning không còn là một lựa chọn xa xỉ mà đã trở thành nền tảng hạ tầng cốt lõi cho mọi dự án AI chuyên nghiệp. Nếu lựa chọn đúng ngay từ đầu, bạn không chỉ tối ưu chi phí mà còn rút ngắn thời gian phát triển sản phẩm, tăng lợi thế cạnh tranh và đảm bảo hệ thống AI vận hành ổn định 24/7.

Dù bạn là cá nhân nghiên cứu, startup công nghệ hay doanh nghiệp lớn, việc xây dựng máy chủ AI phù hợp sẽ là bước đi chiến lược giúp khai thác tối đa sức mạnh của deep learning trong thực tế.